¿Qué es GPT?

GPT significa "Generative Pre-trained Transformer" (Transformador Generativo Preentrenado, en español) y es un tipo de modelo de lenguaje desarrollado por OpenAI. GPT utiliza una arquitectura de red neuronal llamada Transformer, que es especialmente eficaz en tareas de procesamiento de lenguaje natural.

La clave de GPT radica en su capacidad para aprender patrones y estructuras del lenguaje a partir de grandes cantidades de datos pre entrenados. Esto significa que el modelo se entrena inicialmente en grandes conjuntos de datos antes de ser afinado para tareas específicas.

Estos modelos son capaces de realizar diversas tareas relacionadas con el lenguaje natural, como traducción automática, generación de texto, respuesta a preguntas, completar oraciones y más, todo sin necesidad de entrenamiento adicional para tareas específicas. Esto hace que GPT sea versátil y útil en una variedad de aplicaciones.

La capacidad de que los usuarios entrenen su propio GPT se refiere a la posibilidad de adaptar un modelo de lenguaje GPT preentrenado a tareas específicas o dominios particulares.

Esta adaptación o afinamiento se conoce como "ajuste fino" (fine-tuning) y permite a los usuarios personalizar el modelo según sus necesidades.

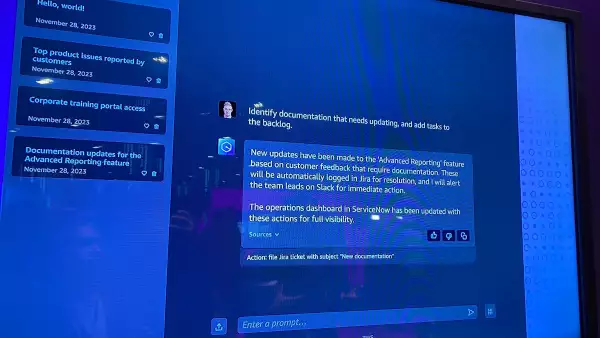

Por ejemplo, si alguien desea utilizar un modelo GPT para una tarea específica, como crear un chatbot, generar contenido específico, hacer traducciones especializadas o generar código, puede entrenar el modelo en datos relevantes para esa tarea específica.

La posibilidad de entrenar chatbots y personalizarlos ya es algo que están haciendo otras empresas, como es el caso de Bedrock de Amazon Web Services (AWS) o Copilot de Microsoft.