Esta respuesta llega un día después de que se dieran a conocer conversaciones entre Meta y Google, que afirman un posible acuerdo entre ambas firmas para utilizar las Unidades de Procesamiento Tensorial (TPU) de Google, especializadas en cargas de trabajo de IA, además la posibilidad de que Meta alquile la infraestructura de Google Cloud para seguir con el entrenamiento de sus grandes modelos de lenguaje.

Y es que un trato de esta magnitud sería el inicio para un cambio de paradigma dentro de la industria de la IA, dominada por Nvidia, pues de concretarse, Google dejaría de usar sus TPU de forma exclusiva e iría a la caza del mercado que domina Nvidia.

Esto provocó que las acciones de Nvidia cayeran un 3%, por lo que la respuesta también forma parte de los intentos de la firma por apaciguar las aguas entre los inversionistas, quienes se mostraron preocupados de que pueda perder una parte de su dominio en la industria de los chips de IA.

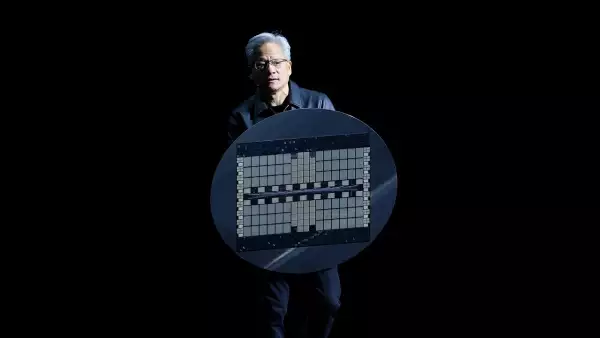

Según cifras de AI Invest, Nvidia domina el mercado de los chips para el entrenamiento de Inteligencia Artificial, gracias a su procesador Blackwell, y si bien existen otras opciones, como las de AMD, Intel o AWS, ninguna se equipara al dominio de Nvidia, que ocupa alrededor del 90% de la industria.

Por ello es que un posible acuerdo con Meta sería tan importante, pues demostraría que puede existir un suministro de componentes diversificado y así reducir la dependencia de Nvidia.

Además, el hecho de que haya sido Meta quien esté incentivando esta posible alianza también es un tema significativo, pues se trata de uno de los mayores inversores de la industria, con un gasto de capital de entre 70,000 y 72,000 millones de dólares tan solo para este año.

Como parte de sus argumentos, Nvidia dijo que sus chips son más flexibles y potentes. Incluso señaló que Blackwell ofrece “mayor rendimiento, versatilidad y fungibilidad” que las opciones de diferentes marcas.

Google, por su parte, cuenta con sus TPU que hasta el momento usa de forma interna o bien los alquila a través de la infraestructura de Google Cloud, sin embargo, también recurre a la infraestructura de la propia Nvidia para entrenar sus modelos, como Gemini, algo que Huang destacó en su informe de resultados financieros la semana pasada.