Luis Caro Pérez, líder de Cloud e IA en AWS Latinoamérica, señaló que la disponibilidad de estos chips responde a tener una infraestructura propia y a contar con productos de hardware personalizados a las necesidades de la empresa.

“La versión 3 ya estaba disponible y ya estamos trabajando en la versión 4. Este producto está disponible para todos los clientes, pero pueden elegirlo quienes usan la tercera capa, ya que ellos escogen qué procesador usan”, precisó Caro.

Dentro de las ventajas que tiene este nuevo producto es que ofrecen hasta 4.4 veces más rendimiento computacional, 4 veces mayor eficiencia energética y casi 4 veces más ancho de banda de memoria que los Trainium2 UltraServers, permitiendo a organizaciones de todos los tamaños entrenar modelos de IA más grandes más rápido y atender a más usuarios a menor costo.

Pero este movimiento también es una tendencia que otras empresas siguen, como Google Cloud, y aunque ambas han dicho que no quieren vender semiconductores como Nvidia, lo que sí quieren es asegurarse de que la infraestructura con la que entrenan y operan sus modelos sea lo suficientemente rápida, eficiente y —sobre todo— barata como para sostener esta nueva economía de IA generativa que exige miles de millones de dólares en cómputo cada año.

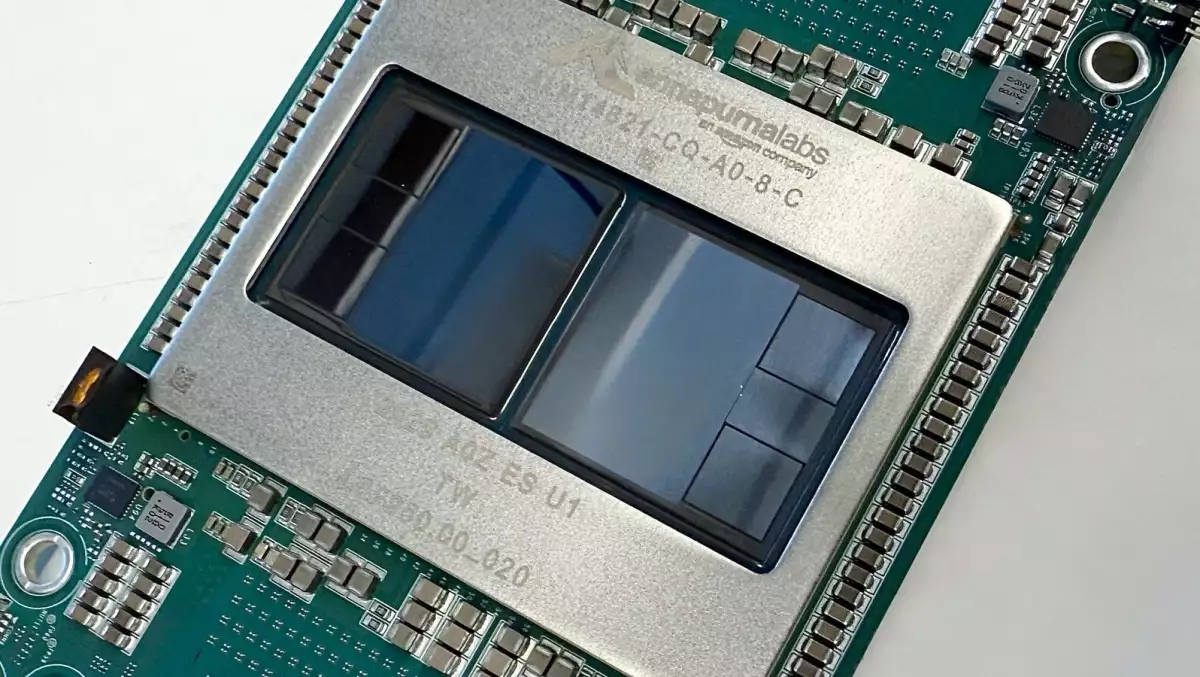

En el caso de AWS, Trainium 3 representa la ambición más clara de convertir su nube en una fábrica industrial de modelos de IA. El chip no busca ser una copia del H100, sino una pieza profundamente optimizada para su propio ecosistema.

El chipset se integra directamente con los servicios de alto nivel de la compañía, desde Bedrock hasta los nuevos modelos Nova, y le permite ofrecer a sus clientes una alternativa atractiva frente a la inflación del cómputo basada en GPUs. Además, con clientes ancla como Anthropic utilizando cientos de miles de estos chips, AWS demuestra que su apuesta también es industrial.

Google, por su parte, compite desde una posición distinta pero igual de poderosa. Su experiencia en el diseño de chips específicos para IA lleva casi una década iterando sobre las TPUs que alimentan servicios masivos como Search, Photos o Maps. Las nuevas generaciones pensadas para Gemini perfeccionan un hardware a la medida para resolver sus propias necesidades, y podría abrir una nueva vertical de negocio, más allá del autoconsumo.

Mientras tanto, Nvidia sigue siendo el vértice del mercado de aceleradores de IA y conserva un dominio casi absoluto gracias a su ecosistema de software y su red de socios, pero conforme estos gigantes de Cloud desarrollan alternativas internas, parte de la demanda se redistribuye.