En 2012 una nueva tendencia revolucionó las redes sociales: el reto de Gangnam Style. En su momento esta canción fue un hit mundial, convirtiéndose en el vídeo de Youtube más reproducido del año. El reto consistía en imitar los pasos de baile del rapero coreano PSY, pero actualmente algunos de los challenges han tomado un giro peligroso.

Los retos peligrosos no te harán famoso: restricciones de las plataformas

Este podría considerarse uno de los primeros challenges en internet; un reto o desafío que se vuelve viral. Suelen comenzarlos youtubers, influencers o personas famosas. Entre ellos podemos encontrar desde bailes hasta campañas para una causa, como lo fue en su momento el “Ice Bucket Challenge”, que buscó generar conciencia a favor de las personas que padecen esclerosis lateral amiotrófica.

Actualmente los retos se han vuelto parte del paisaje cotidiano de las redes sociales. Suelen viralizarse a través de un hashtag y migrar de plataforma en plataforma.

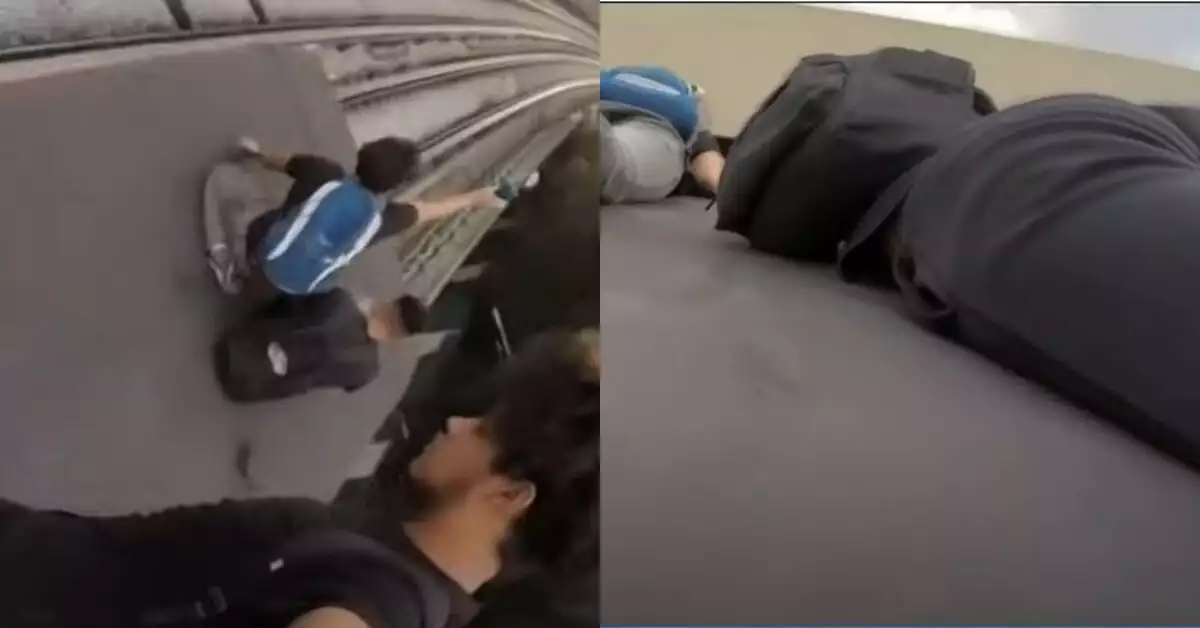

Sin embargo, algo que ha llamado la atención es que algunos de estos retos pueden llegar a ser peligrosos. Challenges como el “Blackout Challenge”, uno de los más buscados en Tik Tok, fue el causante de la muerte de al menos cuatro menores alrededor del mundo, pues consistía en aguantar la respiración el máximo tiempo posible hasta perder la consciencia y luego contar la experiencia.

Por esto, las plataformas han sido conscientes de la evolución que han tenido los retos a lo largo de la historia y han implementado medidas para intentar mitigar los riesgos y que los usuarios no fomenten retos que puedan atentar contra la integridad de las personas. Te los explicamos:

Políticas en Instagram y Facebook

El centro de transparencia de Meta tiene un apartado que habla sobre la organización de actos dañinos y promoción de la delincuencia que menciona: “Para prevenir y evitar daños offline, y la imitación de dicho comportamiento, no permitimos que las personas faciliten, organicen, promocionen o admitan determinadas actividades criminales o dañinas dirigidas a personas, negocios, propiedad o animales”.

En dicha política mencionan que está prohibido publicar contenido “que represente, promueva, defienda o aliente la participación en desafíos virales peligrosos”.

Meta, segundo reporte trimestral 2022

A su vez, está prohibido el contenido que exponga a las personas, haga daños a animales, a la propiedad o fraude electoral o censal.

También queda prohibido publicar contenido que ponga en riesgo a personas LGBTQI+ al revelar su identidad sexual en contra de su voluntad o sin su consentimiento y contenido que ponga en riesgo a mujeres sin velo, en el caso de su religión, al revelar su imagen sin velo en contra de su voluntad o sin su consentimiento.

Cuando alguien hace este tipo de publicaciones, la plataforma le hace saber que incumplió las normas comunitarias, ofrecen una explicación sobre el motivo por el que se eliminó el contenido, solicitan comentarios y dan derecho a la posibilidad de réplica.

Retos virales peligroso en Youtube

Youtube es, de acuerdo con un estudio de Hootsuite , la segunda página web más visitada del mundo con 1,700 millones de visitantes únicos al mes, lo que implica un importante reto y responsabilidad en torno a la seguridad de sus videos.

De acuerdo con un comunicado enviado a este medio, de enero 2022 a marzo de 2022 la plataforma removió 4,410,349 canales por violar los lineamientos de la comunidad.

A su vez, también mencionaron: “YouTube está construido bajo la premisa de la apertura. Mantener una plataforma abierta es uno de los factores más importantes, pero la apertura trae también algunos retos, por lo que los esfuerzos de responsabilidad están basados en las “4Rs” que son las siguientes:

- Remover el contenido que viola los Lineamientos de la Comunidad : Para esto, utilizan la combinación de Machine Learning y personas, eliminan el contenido infractor, buscan fuentes autorizadas y reducen la difusión de contenido problemático (en este blog escrito por Neal Mohan encontrarás más información).

- Reducir el contenido que está en la línea entre lo permitido y lo que no: A través de sus sistemas de recomendación intentar reducir el contenido dudoso que pueda violar los Lineamientos de la Comunidad. Para determinar esto, cuentan con un equipo de consultores externos y eliminarlos. En este link puedes ver cuáles son los esfuerzos de la plataforma para combatir la desinformación.

- Resaltar fuentes autorizadas y verificadas: Para destacar las fuentes autorizadas, las personas que llegan a YouTube reciben noticias a través de estantes de noticias de última hora y paneles de información.

- Recompensar contenido que cumpla con sus estándares: recompensan estos videos con con anuncios, pues consideran que la monetización es un privilegio.

Las políticas de Tik Tok

Esta es la plataforma de retos por excelencia, pues la gran mayoría de los challenges se encuentran aquí. Por esto, la red social ha tenido que ser cuidadosa con los videos y toma numerosas medidas.

De acuerdo con su página oficial, “el contenido en TikTok primero se analiza mediante un algoritmo que identifica y reporta posibles infracciones de las normas, como desnudez o contenido violento y gráfico. Cuando se detecta una infracción de las Normas de la comunidad, este se elimina automáticamente o se reporta para que lo revise de forma adicional nuestro Equipo de Seguridad”.

En caso de que se detecte una infracción se elimina el video y se informa al creador sobre el motivo. Así como en Meta, también se da la oportunidad de solicitar la revisión de la eliminación directamente desde la aplicación.

Por otro lado, el hecho de infringir las normas con más frecuencia resultará en más penalizaciones, incluida la suspensión temporal o permanente de la cuenta. Si es la primera infracción, se envía una notificación, aunque si la infracción incumple la política de tolerancia cero, dará lugar a un bloqueo automático.

Si se cuentan con varias infracciones, las sanciones van desde un bloqueo temporal hasta un bloqueo permanente. Dentro de su política de tolerancia cero se encuentran infracciones como la publicación de contenido relacionado con abuso sexual de menores.

También pueden bloquear un dispositivo para ayudar a prevenir la creación de cuentas en el futuro.